Ob zur Einordnung von Symptomen, zur Erklärung medizinischer Fachbegriffe oder zur Unterstützung bei Gesundheitsrecherchen: Immer mehr Menschen nutzen künstliche Intelligenz (KI) wie ChatGPT auch im medizinischen Kontext. Doch wie zuverlässig sind die Auskünfte – und welche Risiken drohen, wenn Technik ärztlichen Rat ersetzt?

Informationen oft lückenhaft oder falsch

Dr. Sven Zenker, ärztlicher Leiter Stabsstelle Medizinisch-Wissenschaftliche Technologieentwicklung und -koordination (MWTek) am Universitätsklinikum Bonn (UKB), erläutert: „Sprachmodelle wie ChatGPT sind beeindruckend – sie formulieren so überzeugend, dass man ihnen leicht zu viel zutraut. Dabei sind die gelieferten Informationen oft lückenhaft oder sogar falsch, besonders wenn keine gesicherten Daten vorliegen.“

Das Problem: KI-basierte Sprachmodelle „halluzinieren“ – sie erfinden teils Informationen, die schlicht falsch sind oder für die es jedenfalls keine Belege gibt, ohne dies kenntlich zu machen. Dabei klingen die Antworten oft so geschliffen, dass selbst Fachleute kritisch hinschauen müssen. „Diese Modelle formulieren besser als so mancher Profi – leider auch, wenn sie gar nicht wissen, wovon sie sprechen“, erklärt Zenker.

KI schafft Zugang zu Gesundheitswissen

Zenker sieht in KI dennoch ein wertvolles Instrument – vor allem zur Verbesserung des Zugangs zu Gesundheitswissen: „Für Laien, die keine medizinische Fachsprache beherrschen, kann ChatGPT helfen, komplexe Inhalte verständlich aufzubereiten. Auch bei Recherchen unterstützt es deutlich intuitiver als klassische Suchmaschinen.“ Doch die Risiken sind erheblich: Wer Symptome falsch interpretiert oder sich durch die KI in falscher Sicherheit wiegt, könnte ärztliche Hilfe zu spät suchen – mit womöglich gravierenden gesundheitlichen Folgen.

Empfehlungen für eine sichere Nutzung von ChatGPT bei Gesundheitsthemen:

- ChatGPT ist kein Ersatz für ärztliche Beratung: Die KI kann bei der Vorbereitung oder Nachbereitung eines Arztgesprächs helfen – bei akuten Beschwerden oder Diagnosen sollte man unverzüglich ärztlichen Rat einholen.

- Kritisches Denken ist entscheidend: Sprachlich perfekte Antworten sind nicht automatisch korrekt. Nutzer sollten Informationen gegenprüfen und sich nicht allein auf die KI verlassen.

- Besonders vorsichtig bei sensiblen Themen: Für psychische Erkrankungen, medizinische Notfälle und kritische Entscheidungen ist professionelle Hilfe unverzichtbar. ChatGPT sollte hier allenfalls begleitend genutzt werden – keinesfalls als Therapieersatz. Auch kann die KI-unterstützte intensive Beschäftigung mit medizinischen Fragen gerade in psychisch belastenden Situationen auch schädlich oder sogar gefährlich sein – ein Gespräch mit einem menschlichen Experten ist hier oft die bessere Wahl.

- Medizinische Zertifizierung prüfen: Wer medizinische Apps nutzt, auch solche mit KI-Funktionen, sollte auf eine CE-Kennzeichnung achten. Nur dann gelten sie als geprüfte Medizinprodukte – anders als die Standardversion von ChatGPT.

- Fachliche Kontrolle bei professionellem Einsatz: Im klinischen Kontext können Sprachmodelle zum Beispiel bei der Literatursuche oder beim Vereinfachen von Fachtexten unterstützen. Für alle entscheidungsrelevanten Inhalte bleibt jedoch ärztliche Verantwortung und Kontrolle in jedem Fall unerlässlich.

Aufklärung und strenge Qualitätskontrollen

Zenker fordert neben Aufklärung auch strenge Qualitätskontrollen: „Für medizinische KI-Anwendungen gibt es in der EU bereits hohe regulatorische Hürden – zurecht. Werkzeuge für Diagnostik- oder Therapieempfehlungen müssen als Medizinprodukt zugelassen sein. Standard-KIs wie ChatGPT erfüllen das derzeit nicht.“

Die KI-Verordnung der EU ordnet KI-Anwendungen, die als Medizinprodukte höherer Risikoklassen eingestuft werden, zusätzlich regelmäßig als sogenannte Hochrisiko-KI-Systeme mit verschärften Qualitätssicherungs- und Zulassungsanforderungen ein, um Gefahren für Patienten und Anwender zu minimieren. Diese hohen Anforderungen aus Medizinprodukterecht und KI-Verordnung stellen gerade große Sprachmodelle vor erhebliche Zulassungshürden, die aber gut begründet sind: „Die Halluzinationen dieser Systeme entstehen oft gerade dann, wenn Informationen fehlen – also genau in den Situationen, wo Vorsicht geboten wäre.“

Zukunftsperspektive: Unterstützung, nicht Ersatz

In Zukunft könnten KI-Modelle gezielter eingesetzt werden – etwa in der Patientenaufklärung, der individuellen Informationsaufbereitung oder zur Entlastung medizinischen Fachpersonals bei repetitiven Aufgaben. „Solange klar ist, dass KI-Systeme keine medizinische Entscheidung treffen dürfen, können sie dazu beitragen, Gesundheitskompetenz zu stärken, knappes medizinisches Fachpersonal zu entlasten und zunehmend auch Diagnostik und Therapie zu optimieren“, resümiert Zenker.

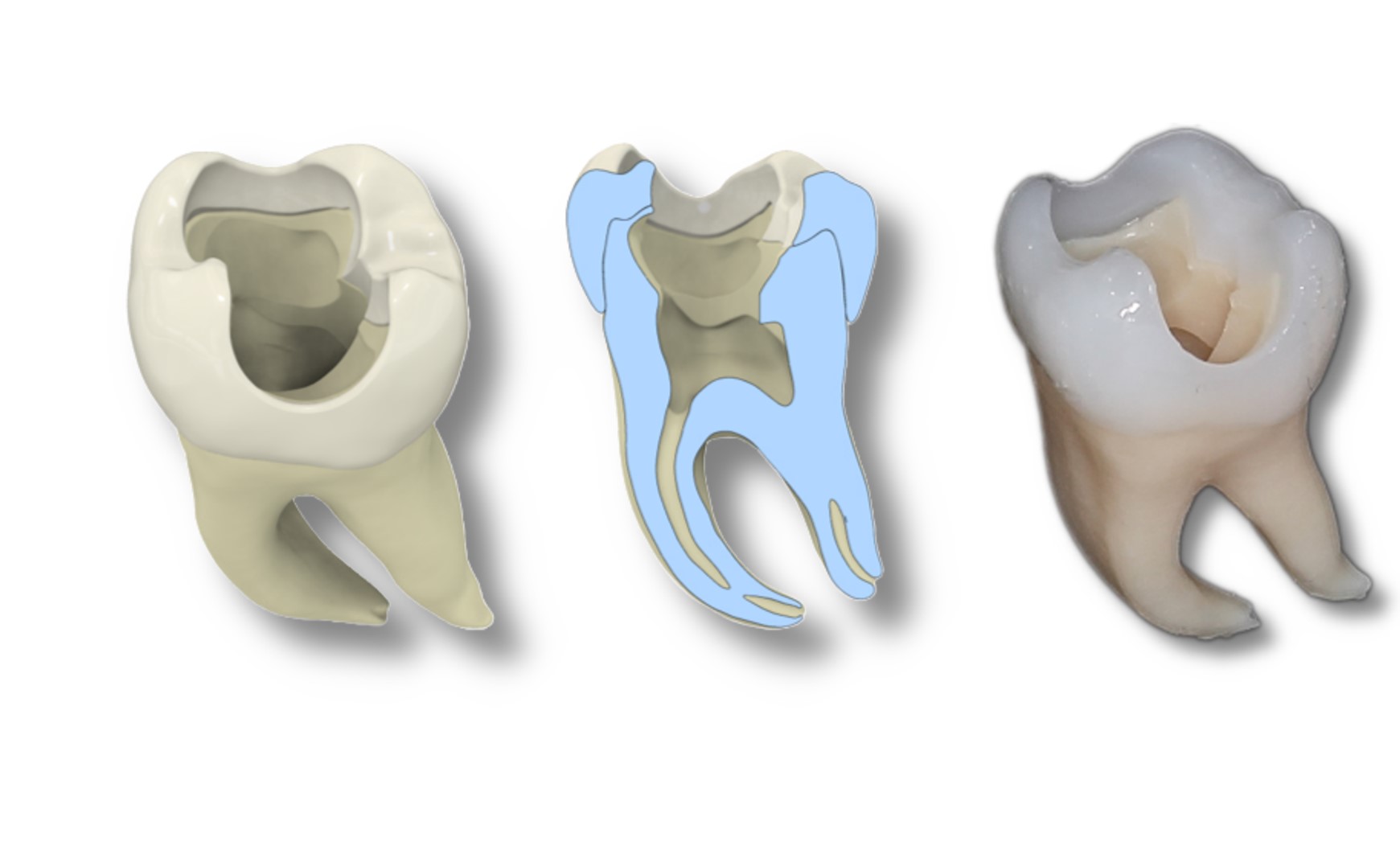

Besonders vielversprechend seien spezialisierte KI-Anwendungen, etwa zur Analyse von Röntgenbildern oder EKGs – dort, wo gezielte Algorithmen in enger Abstimmung mit ärztlicher Expertise eingesetzt werden und schon heute zum Teil übermenschliche Leistung erbringen.

Titelbild: khunkornStudio - stock.adobe.com